Gigabit-Ethernet

16.02.2011, 06:00 Uhr

auf Tempo getrimmt

Ethernet ist in den meisten Netzen die Technologie der Wahl. Ist die bewährte Technologie auch für die explodierenden Bandbreiten in den Rechenzentren und Carrier-Netzen gerüstet?

Der Autor ist Presales Manager für die Region DACH bei Extreme Networks Bei Netzwerkverantwortlichen ist die Ethernet-Technologie vor allem deshalb so beliebt, weil sie als kostengünstig, zuverlässig und skalierbar gilt. Aus diesen und vielen anderen Gründen läuft der meiste Datenverkehr dieser Welt – zumindest beim Sender und Empfänger – heute aller Wahrscheinlichkeit nach über ein Ethernet-Netzwerk. Doch kann die inzwischen nicht mehr ganz junge Netzwerktechnologie mit dem steigenden Hunger nach Bandbreite mithalten? Was kommt nach 10-Gigabit-Ethernet? Um diese Fragen zu klären, ist ein kurzer Blick auf die Kräfte nötig, die unsere Ethernet-Bandbreiten nach oben treiben.

Virtualisierung braucht Bandbreite

Ein treibender Faktor für immer schnelleres Ethernet in Unternehmen und Rechenzentren ist die Virtualisierung von Servern und Speicherressourcen. Dabei versuchen Rechenzentrumsbetreiber, durch Reduktion ihrer physikalischen Rechner deren Stromverbrauch, die Klimatisierung sowie die optimale Nutzung von Stellfläche in den Griff zu bekommen. Gleichzeitig sind sie bemüht, das Maximum an Rechenleistung, Netzwerkkapazität und Speicherplatz aus ihrer IT herauszuholen. Anfangs setzte man zunächst auf eine hohe Serverdichte im Rack – beispielsweise mithilfe von Blade-Servern. Allein ein solches Server-chassis mit acht oder mehr Servern ist in der Lage, mehr als 10 Gbit/s an Datenverkehr in das Netzwerk zu schieben. Kommt jetzt noch eine bessere Auslastung der Hardware-Ressourcen durch virtualisierte Server hinzu, steigt der mögliche Datenausstoss weiter an. Denn eine zunehmende Dichte von virtuellen Servern pro physikalischem Server verursacht entsprechend mehr Datenverkehr auf dessen Netzwerkkabel. Dies ist letztlich auch der Grund, warum Netzwerkmanager kaum umhinkommen, ihre leistungsstarken Server auf 10-Gbit-Ethernet zu migrieren. Die mittelfristige Folge ist dann jedoch auch eine Verzehnfachung des Datenverkehrs am Rande des Netzwerks (Edge). Neben den dortigen Switches müssen dann auch der Netzwerkkern (Core) sowie etwaige Aggregationsebenen im Netzwerk proportional mit skalieren.

Gigabit-Ethernet im SAN

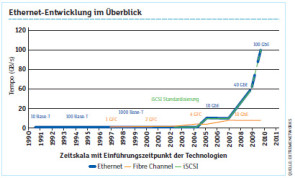

Ein weiterer Treiber für schnelleres Ethernet ist die Anbindung von Storage-Ressourcen an die Serverlandschaft über iSCSI. Zu Beginn unterstützte iSCSI dabei Geschwindigkeiten von 1 Gbit/s, was keine wirkliche Konkurrenz zur bislang meist im SAN eingesetzten Fibre-Channel-Technologie war. Denn deren Speichernetze ermöglichten Verbindungen mit 4 Gbit/s und später sogar 8 Gbit/s. Doch mit der Einführung von 10-Gigabit-Ethernet (10 GbE) fingen auch hier Veränderungen an (siehe Grafik). Denn jetzt spielen Netzwerkmanager zunehmend mit dem Gedanken, diese Technologie nicht nur für ihre LAN-Verbindungen, sondern auch für die Integ-ration von SAN-Verkehr (Storage Area Network) über dasselbe physikalische Ethernet-Netzwerk einzusetzen. Ein solcher Wechsel verringert dabei nicht nur die Zahl der physikalischen Verbindungen im Netzwerk. Er reduziert auch die allgemeine Komplexität sowie damit verbundene Kosten. Denn durch den Einsatz von iSCSI über Ethernet wird ein eigenes kostspieliges Fibre-Channel-Netzwerk überflüssig.

Vorbereitet auf die Zukunft

Die Entwicklung von Rechenleistung folgt auch heute noch weitestgehend Moores Law und verdoppelt sich ungefähr alle 24 Monate. Eine Studie der Higher Speed Study Group (HSSG) des Weltverbands der Informatik-Ingenieure IEEE zu den Anforderungen an das Ethernet der nächsten Generation fand dabei heraus, dass es eine deutliche Divergenz zwischen den Wachstumsraten von Bandbreite bei Rechenanwendungen und der für die Aggregation von Netzwerken gibt. Folgt man dieser Erkenntnis, wird zukünftig 10 GbE wahrscheinlich am Rande des Netzwerks verbreitet zum Einsatz kommen, während 40 GbE mehr auf der Aggregationsebene zu finden sein wird. 100 GbE wird dann – zumindest auf absehbare Zeit – seinen Platz vornehmlich als WAN-Medium finden. Grund hierfür sind vor allem die Kosten der optischen Komponenten, die für den Einsatz in Rechenzentren und Unternehmensanwendungen noch zu hoch sind. Mit sinkenden Preisen für 100 GbE wird diese Technologie dann ihren Weg zunächst in das Netzwerk-Core finden, um dort Core-Switches miteinander zu verbinden sowie um Gebäude-, Standort-, WAN- und MAN-Verbindungen (Metropolitan Area Network) für Unternehmensnetze herzustellen. Durch den Einsatz von 40 GbE im Core können Netzwerkmanager bereits heute Kosten sowie Komplexität bei Verkabelung und Konfiguration weiter reduzieren. Eine 40-GbE-Implementierung könnte beispielsweise die Verkabelung im Core auf ein Viertel der heutigen Verkabelung verringern. Eine richtige Switching-Architektur zusammen mit 40 GbE und 100 GbE unterstützt die Betreiber von Rechenzentren zudem dabei, auch die Überbuchungsraten auf den verschiedenen Netzwerkebenen zu reduzieren. Das Ziel ist hier idealerweise eine nicht blockierende Architektur im Core sowie eine Überbuchung von 2,4:1 auf den Agg-regationsebenen. Hersteller entwickeln heute Core- und Aggregation-Switches, die schon auf 40 GbE und 100 GbE vorbereitet sind. Proprietäre Stacking-Methoden können sogar noch höhere Datendurchsätze ermöglichen. Dennoch gibt es auch einen Bedarf an höheren Switching-Möglichkeiten für die Verbindung von Top-of-Rack-Switches (ToR), wenn eine Stacking-Verkabelung nicht genutzt werden kann. Um hier hohe Bandbreiten zur Verfügung zu stellen, können beispielsweise zwei oder mehr 40-GbE-Strecken redundant aggregiert werden. Diese Vorgehensweise stellt aller Wahrscheinlichkeit nach für die meisten Anwendungen auf absehbare Zeit ausreichend Bandbreite für Verkehr auf der

Aggregationsebene bereit.

Aggregationsebene bereit.

Ethernet in Provider-Netzen

Eine der grössten Herausforderungen für Carrier ist, wenn der Bedarf an Bandbreite weiterhin schneller steigt als Moores Law. Carrier wie Serviceprovider verzeichnen typischerweise alle 12 bis 18 Monate eine Verdoppelung der Bandbreite auf ihren Backbones. Ein erhöhter Bandbreitenbedarf dieser Grössenordnung führt dabei zu ernsthaften Herausforderungen für die Gestaltung der SLAs im Umgang mit Bandbreite auf der Aggregationsebene und im Backbone. Internet Service Provider (ISPs), Multiple System Operators (MSOs) und Content Delivery Network Provider (CDNs) sehen dabei alle ein nachhaltiges Wachstum an Bandbreitenbedarf. Dies zwingt wiederum viele dieser Unternehmen dazu, weg von kränkelnden ATM/TDM-Infrastrukturen und hin zu Ethernet zu migrieren. Die Frage ist dabei nicht, ob sie migrieren müssen, sondern ob sie zu 10, 40 oder 100 Gbit/s im Backbone migrieren sollen. Die Möglichkeit, Bandbreite bis um den Faktor 10 zu erhöhen, führt Carrier, Operator und ISPs schliesslich zur Ethernet-Technologie, um so wieder eine Balance zwischen Kosten und Leistung zu erhalten.

Vorteil skalierbarkeit

Der grosse Erfolg von Ethernet bis zum heutigen Tag lässt sich auf die Erschwinglichkeit, Zuverlässigkeit, Einfachheit und Skalierbarkeit der Technologie zurückführen. Aus diesem Grund beginnt und beendet der meiste Netzwerkverkehr heute seine Reise auf Ethernet. Da die Rechenleistung von Anwendungen langsamer wächst als der Datenverkehr bei der Aggregation von Netzwerken, kam die Entwicklung von 40 und 100 GbE gerade zur rechten Zeit, um den Siegeszug von Ethernet fortzusetzen. Denn die hohen Geschwindigkeiten bieten der Technologie eine Perspektive für die nächsten Jahre in Unternehmen, in Rechenzentren und in zunehmender Zahl auch in Carrier-Netzen.